ChatGPT tiene nuevo cerebro (y no lo entiendo)

Se llama GPT-5... y ha tenido un lanzamiento algo escabroso. Hablemos de lo que eso significa para nosotros.

Tenía planeado escribir otro post, y en eso OpenAI lanza GPT-5, la nueva version de ChatGPT. No pude resistirme, así que abrí ChatGPT y le pregunté de frente y sin rodeos “¿Cómo funcionas ahora?”, “¿En qué has cambiado?”

Lo que siguió fue una mezcla de emoción, frustración y desesperación… y aquí te cuento sobre eso.

Disclaimer: Sé que este debe ser uno de los dos mil setecientos treinta y seis posts sobre GPT-5 que has visto esta semana… pero igual quería contarte mi opinión (espero que te sirva).

Hace 96 horas*

Estaba viendo el lanzamiento de GPT-5 por Youtube y todo sonaba muy bien, algún bug por ahí, obviamente mencionaron que se siente como hablar con alguien que tiene un PhD, etc, etc.

Lo que anunciaron fue un modelo que podría adaptarse y decir por si mismo cuando responder rápido y cuando ponerse a pensar antes de darnos una respuesta. Luego hicieron algunas demostraciones que no salieron del todo bien, aunque personalmente no me pareció un problema muy grande. Esas cosas suelen pasar.

Si quieres soplarte ver el lanzamiento, aquí te dejo el video (1h 17 min).

Todo sonaba increíble, hasta que la gente empezó a usarlo.

*Sé que no pasó hace 96 horas, sino más como 120, pero déjame ponerlo así para un efecto dramático.

La rebelión de los usuarios

La gente empezó a quejarse en Reddit y Twitter (sí, aún le digo Twitter, toma eso Elon). Algunos hasta llegaron a cancelar su suscripción y se pasaron a Claude o a Gemini. No es lo que OpenAI esperaba cuando presentó su “flagship model” así que Sam Altman, su CEO, tuvo que salir a hacer control de daños.

Pasó de todo, Sam se disculpó, prometió traer de vuelta a GPT-4o, aumentar los límites de uso, etc etc. Todos estos cambios se han estado dando mientras escribo este post así que disculpa si se nota un poco el caos aquí también :P

Hay un tipo de comentarios que me llamó la atención, era la gente que le había agarrado cariño a su ChatGPT y estaba acostumbrada a conversar con GPT-4o.

Ellos sintieron que la personalidad de su asistente cambió de la noche a la mañana, y podíamos ver quejas que decían cosas como “GPT-4.5 era mi amigo…”, Hace unas semanas escribí sobre cómo humanizamos a la IA ¿te imaginas que te quiten a tu amigo?

La cosa se había puesto seria.

Para entender por qué tanto caos, hablemos de qué ha pasado con los modelos de ChatGPT.

One brain to rule them all

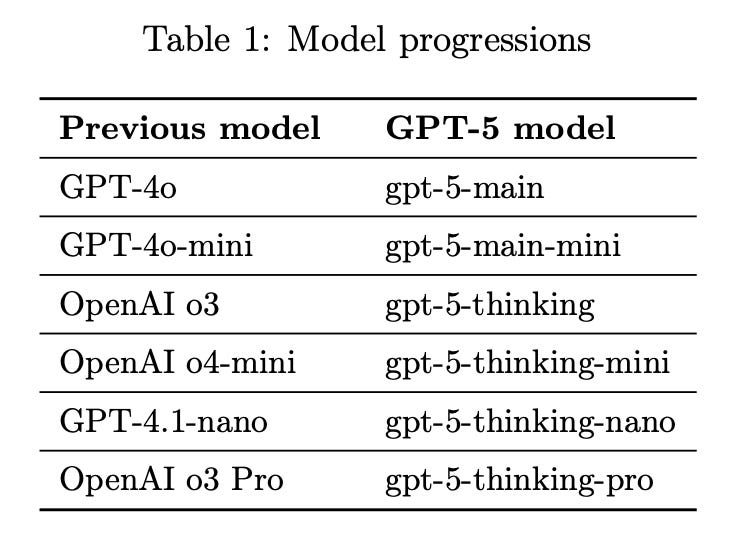

Lo primero que tienes que saber es que ya no vas a ver 37 modelos diferentes. ¿Te acuerdas que antes teníamos “GPT-4o”, “4.1o”, “4.5o preview”, “o3”, “o3-mini”, “o1-preview”? (sigo pensando que OpenAI es la peor para darle nombre a sus modelos).

Pues olvídate de eso, hoy todo es GPT-5, punto.

Eso significa que todos tus chats, incluyendo los antiguos, desde ahora los maneja GPT-5 sin importar qué modelo hayas seleccionado antes.

Para ponerlo en perspectiva, ahora hasta esa conversación que empezaste hace tres meses con o3 para resolver un problema complicado, ahora continuará con GPT-5.

Imagina que desde hace meses estás viendo un terapeuta, y de repente, su hermano gemelo (que tiene otra personalidad) toma su lugar y continúa tus sesiones. Algo así.

Para complicarlo un poquito más, esta última versión no es un modelo en sí, sino la integración de al menos cinco modelos diferentes: unos rápidos y otros que se toman más tiempo para pensar las cosas antes de responder. Cuando hablas con ChatGPT, hay una especie de “director de orquesta" que decide cual de los modelos usar para responder lo que acabas de preguntar.

Mira los nuevos modelos y su parecido con los anteriores:

Aquí puede haber un problema… antes tú eras el que escogía el modelo que querías usar, ahora la misma IA es la que decide si pensar más o no, y encima de eso no es transparente sobre cual de esos modelos está usando!

Parece que le estamos dando mucho más control a la IA y no sabemos qué está pasando por dentro. Es como manejar un auto mecánico vs uno automático, definitivamente un carro automático es más cómodo, pero si quieres realmente controlar el auto, nada como una transmisión mecánica.

Es importante, así que voy a repetirlo: ahora un algoritmo decide por ti.

Te estarás preguntando “¿Pero Germán, entonces eso rompe cambia todo?” Yo me pregunté lo mismo… y sí, hay cosas que han cambiado, te cuento.

¿Qué significa eso para mis conversaciones?

Sencillo! Las nuevas conversaciones se harán ahora sólo con GPT-5… y las antiguas también… aunque eso ya no es tan sencillo :P

Aproveché el para darle una mirada a algunas de mis conversaciones pasadas. Encontré los chistes que le conté para el artículo sobre la IA y el humor, una conversación analizando mi rutina de ejercicio, y hasta una laaaaaaaaaaaarga charla técnica donde ChatGPT me ayudó a escoger mi próximo amplificador integrado (si es que algún día puedo pagarlo).

Ahora todas estas conversaciones seguirán con GPT-5 y aquí es donde las cosas se pueden poner raras.

Tu IA y su mala memoria

¿Sabes que cada vez que le escribes a ChatGPT le estás enviando toda la conversación? Sí toda.

Es decir que, si por ejemplo llevas meses hablando con ChatGPT sobre amplificadores integrados y cómo se escucharían con el resto de tu equipo HiFi, cuando escribas el próximo mensaje, la IA va a leer todos desde el principio antes de responderte (y eso pasa cada vez que escribes).

Obviamente estas conversaciones no pueden ser infinitas. Los modelos tienen límites (de hecho cada modelo puede tener límites diferentes), y lo que hacen cuando sienten que se están acercando al tope es resumir la conversación y seguir hablando en base a ese resumen.

Ese es su “gran truco” para mantener el hilo. Pero como en todo resumen, se pierden detalles. ¿Te ha pasado alguna vez que durante una conversación larga tu IA empieza a responder raro? Es muy probable que sea por eso.

Estuve leyendo por ahí y parece que la ventana de contexto de GPT-5 (así se le llama al límite de tamaño de la conversación) es de treinta y dos mil tokens, algo parecido a treinta y dos mil palabras, sumando tus preguntas y sus respuestas. Esto no es mucho, modelos como Claude tienen doscientos mil y ni hablar de Gemini que tiene una ventana de contexto de un millón de tokens.

Sé que no parece mucho, pero debería ser suficiente para tener una buena conversación antes que tenga que “resumirla” y perder detalle.

Sobre tus chats viejos: como los anteriores modelos tenían limites más pequeños, puede pasarte que el chat ya esté resumido. Así que GPT-5 no está leyendo tu conversación original sobre amplificadores sino la versión resumida. No big deal.

Las tareas programadas

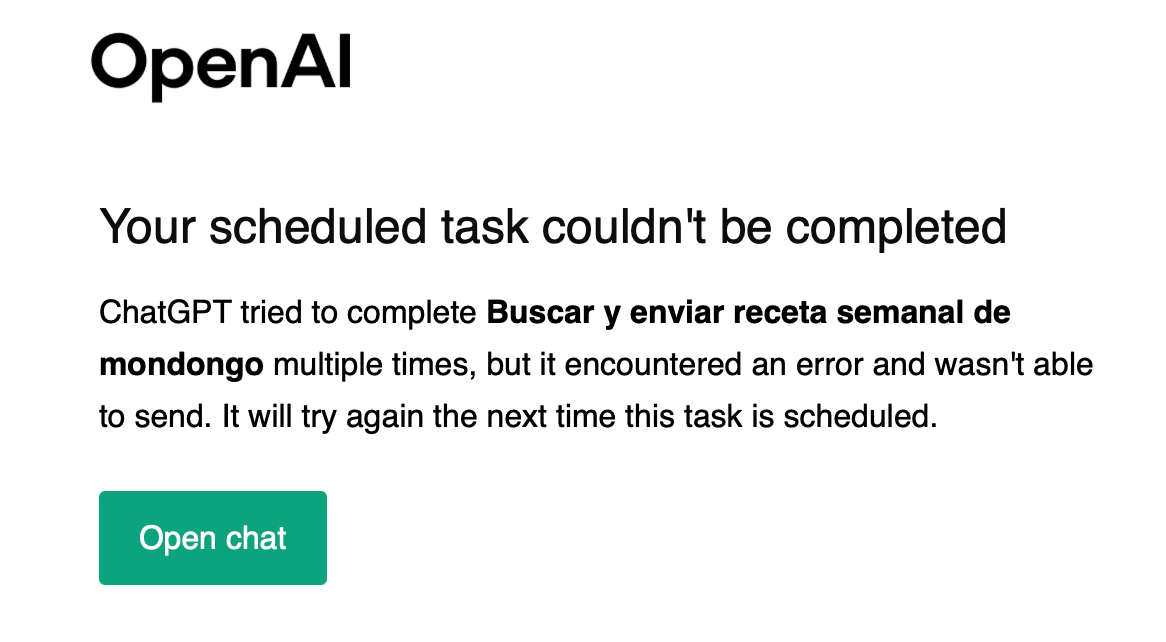

No todo es malo, parece que algunas cosas han mejorado. Ahora puedes configurar tareas programadas desde cualquier chat sin cambiar de modelo!

La semana pasada justo escribí sobre eso y te contaba que para hacerlo había que abrir un chat con un modelo de razonamiento como o3 u o1 y pedirle que programe la tarea.

Update: justo cuando estaba por publicar me llega este correo. Pensaba que andaba todo bien y OpenAI me avisa que mi tarea programada no pudo ser completada.

Debe ser que le dio hipo :(

¿Cómo hacemos que piense?

Antes sabíamos que si cambiamos de modelo ChatGPT podría pensar por más tiempo y (en teoría) responder mejor.

Con GPT-5 eso viene de fábrica. Ahora tenemos ese “director de orquesta” que elige si tu asistente responde rápido y se pone a pensar un poco más antes de responder. Parece que tienes un par de formas de controlar eso.

Primero puedes cambiar el modelo desde el selector, fácil.

La otra opción es que le digas durante la conversación que quieres que se ponga a pensar, puedes usar una frase como: “Quiero que pienses a profundidad”, “Tómate un tiempo para pensar”, “¡Piensa, carajo!” o lo que prefieras. Esto hará que el orquestador seleccione el modelo de razonamiento.

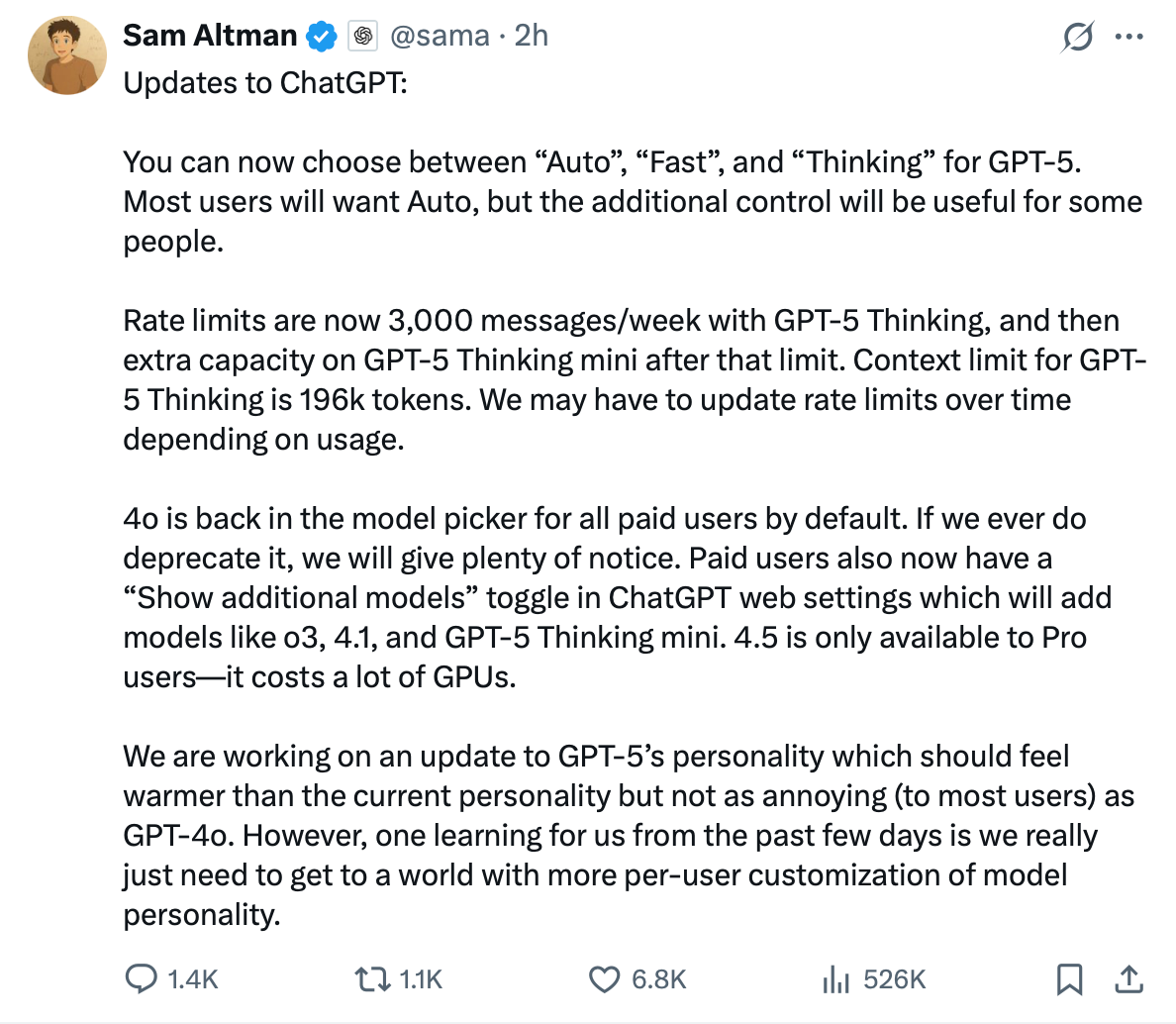

El menú que no se decide

Parece que el menú de selección de modelos no para de cambiar. Cada vez que abro ChatGPT hay algo diferente.

Primero solo veía GPT-5 y GPT-5 Thinking

Luego volvió 4o! (bajo un sub menú de Legacy models)

Luego volvió a cambiar. Ahora resulta que puedo escoger entre Auto, Fast y Thinking (además de poder usar a nuestro querido 4o)

Aquí el Tweet de Sam Altman de ayer que explica este cambio.

Como te dije al inicio, hay mucha gente que está pidiendo aún usar el modelo anterior y OpenAI está trabajando en darles acceso, aunque parece que solo será a los suscriptores de pago.

¿Qué es lo que ha pasado?

Parece que GPT-5 no estuvo a la altura del hype que ha construido. Me imagino que eso de andar diciendo cada cinco minutos que ChatGPT tiene un nivel de PhD solo funciona si realmente tiene ese nivel.

Durante este par de días he escuchado de todo, que genera código de programación muy bueno (no he podido probar eso). De hecho he escuchado buena parte de los usuarios no lo nota más inteligente, parece más un cambio marginal. También he visto reportes de errores de cálculo o de alucinaciones.

Hice la prueba con una operación matemática sencilla que vi por ahí, y ChatGPT falló miserablemente.

Claramente está calculando mal, no es -0.21 es 0.79

Y no soy sólo yo, Twitter está lleno de ejemplos con errores básicos, problemas de lógica y respuestas que suenan menos inteligentes que GPT-4o.

¿Qué digo yo?

¡Meh!

— Germán Martínez

Entiendo que no ha sido el lanzamiento que la gente esperaba y si bien aún podemos conversar con ChatGPT, no lo siento muy estable.

El problema no es solo que tenga errores, después de todo GPT-4o no era perfecto. El problema es la forma como se manejó este lanzamiento… quitar los modelos, perder la transparencia y tratar de básicamente obligar a la gente a usar algo que claramente no estaba listo.

Me imagino que luego de algunos días todo esto se estabilizará y volverá a la normalidad. Mientras tanto, un poco de paciencia no cae mal :)

Sorry de nuevo por el post caótico, publico de una vez antes que aparezcan más cambios y mi post quede desactualizado ;)

Nos leemos,

G

Voy a soltar un dato.

De hecho 🤓 el problema de la operación matemática es por la tokenizacion, hasta que cambien el como se tokeniza (ya hay solucion solo falta implementacion) dejara de pasar ese tipo de errores.

Dejo abajo un video que desarrolla lo que acabo de escribir:

https://youtu.be/7wf7fsI-Gp4?si=wek-4XyLa2p0x9ac

Gracias por tu post, estuvo interesante.